这篇文章将向大家简要介绍机器人夹爪时空位姿感知方面的一篇论文”AnyGrasp”[1]的实现思路,其也是上篇介绍文章GraspNet[2]的后续研究。

空间几何处理模块基本沿用了类似GraspNet的网络结构,但在输出的维度上做了更新:1、depth加了一个等级;2、有一个stable_score的度量(metric),和现有的graspnet的score采用重参化技巧相结合。

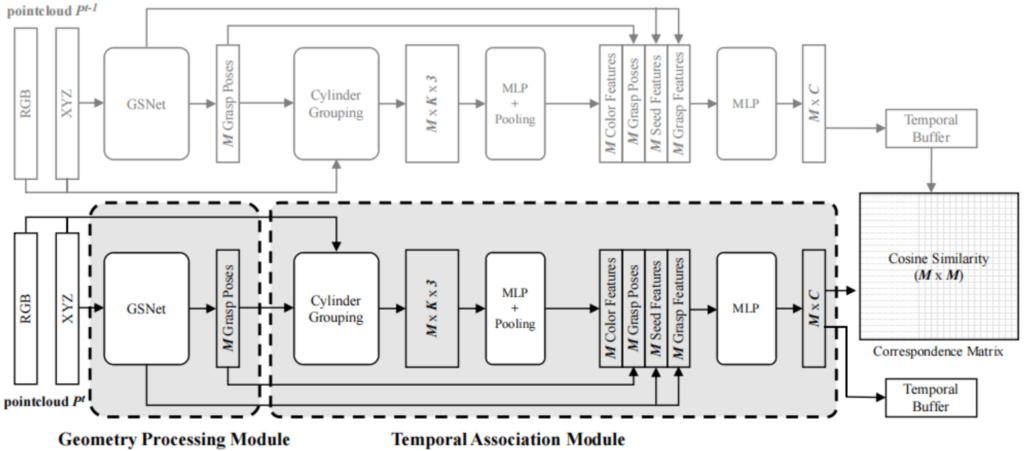

其更多的创新之处在于在空间几何处理模块(左边GSNet部分)的基础之上,添加了一个时间相关的模块(Temporal Association Module)来实现抓取位姿的跟踪功能(grasp pose tracking),该跟踪模块主要组成为(具体可以将解释和图1中的结构图进行对照理解):1、特征提取功能,纹理和颜色可以给tracking提供相关的线索信息,对于种子点的的approaching vector和GSNet中的基于cylinder grouping的特征分组类似的方法对点云的颜色信息进行聚合计算并通过MLP和Pooling后形成颜色特征;2、特征组合功能,和GSNet前向过程形成的相关特征拼接后连接MLP形成M个种子点的夹爪位姿的C个通道的feature输出,并和在时间Buffer里存储的上一帧的夹爪姿态的C个通道特征输出计算相关性(如通过计算特征间的余弦夹角来获取特证间的相似度得分similarity score,形成M*M的对应矩阵correspondence matrix)。在计算loss时,根据上一帧的每一个位姿,将当前帧与其距离在一定小范围内的抓取位姿集合一起计算损失函数,损失函数定义思路为增大相似姿势的相似性抑制距离较大姿势间的相关性,具体可以参考[1]中的公式描述。

其中在训练的过程中,首先训练几何处理模块,待几何处理模块收敛之后,则将其参数进行冻结继续训练连接在后面的时间关联模块。在训练时间模块的时候,对数据集有特殊要求,具体实验时的mini-batch的大小设置为4对点云帧数据,其中每对数据为同一场景下采集时间上连续的点云帧和对应的姿态。

关于代码实现,作者开源了其推理部分的代码,可以参考[3]。

References

- [1]、AnyGrasp: Robust and Efficient Grasp Perception in Spatial and Temporal Domains:https://arxiv.org/pdf/2212.08333

- [2]、GraspNet通用物体抓取

- [3]、anygrasp_sdk: https://github.com/graspnet/anygrasp_sdk.git

Leave a Reply